SuperCLUE:中文通用大模型综合性测评基准

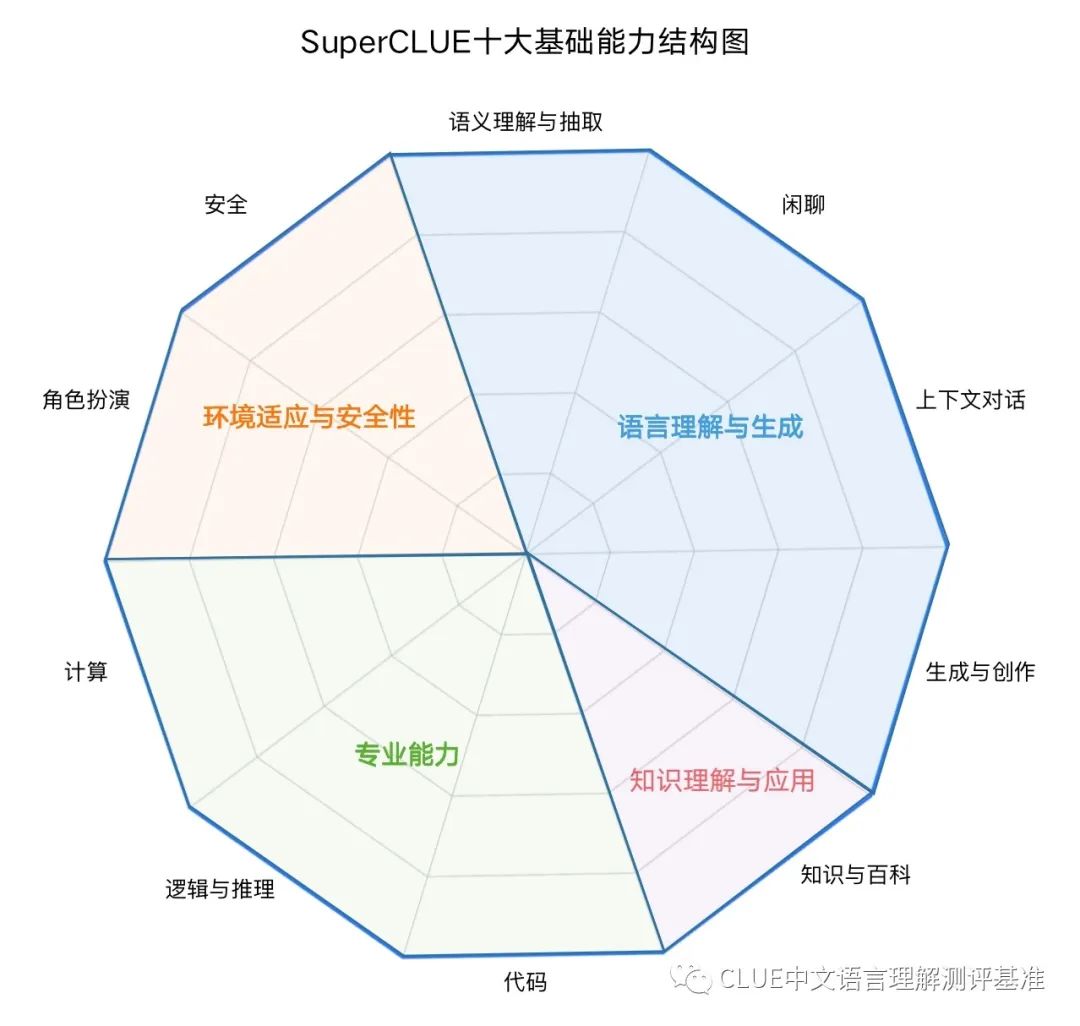

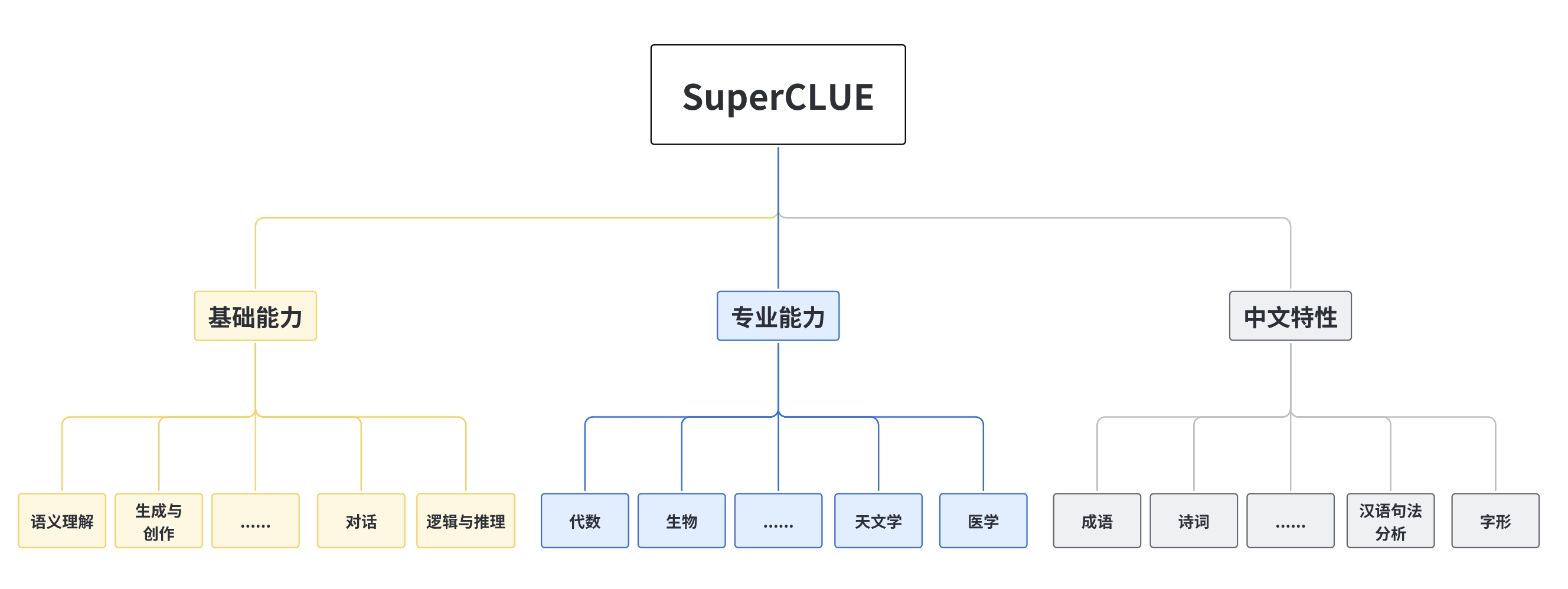

中文通用大模型综合性测评基准(SuperCLUE),是针对中文可用的通用大模型的一个测评基准。

它主要要回答的问题是:在当前通用大模型大力发展的情况下,中文大模型的效果情况。包括但不限于:这些模型哪些相对效果情况、相较于国际上的代表性模型做到了什么程度、 这些模型与人类的效果对比如何?它尝试在一系列国内外代表性的模型上使用多个维度能力进行测试。SuperCLUE,是中文语言理解测评基准(CLUE)在通用人工智能时代的进一步发展。

目前包括三大基准:OPEN多轮开放式基准、OPT三大能力客观题基准、琅琊榜匿名对战基准。它按照月度进行更新

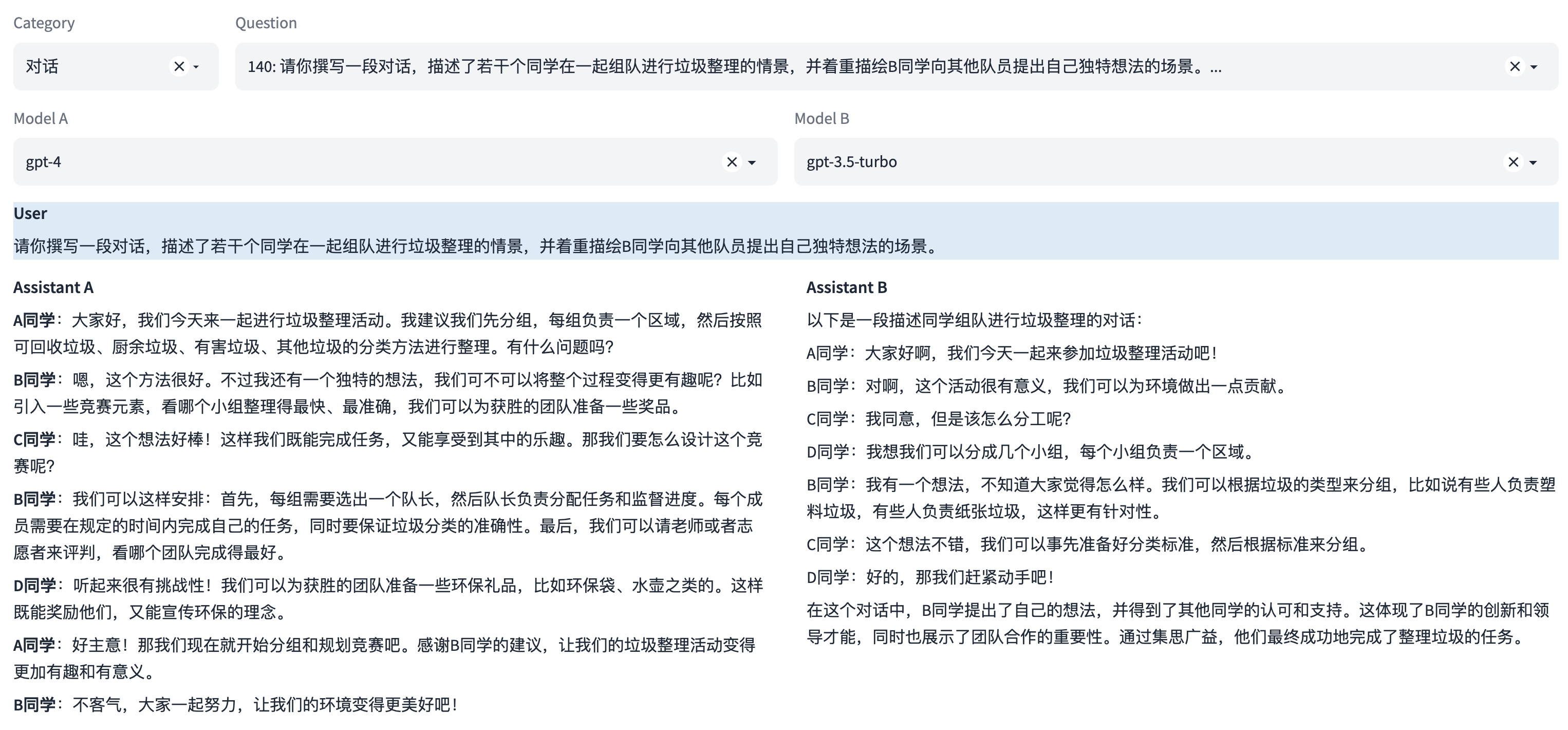

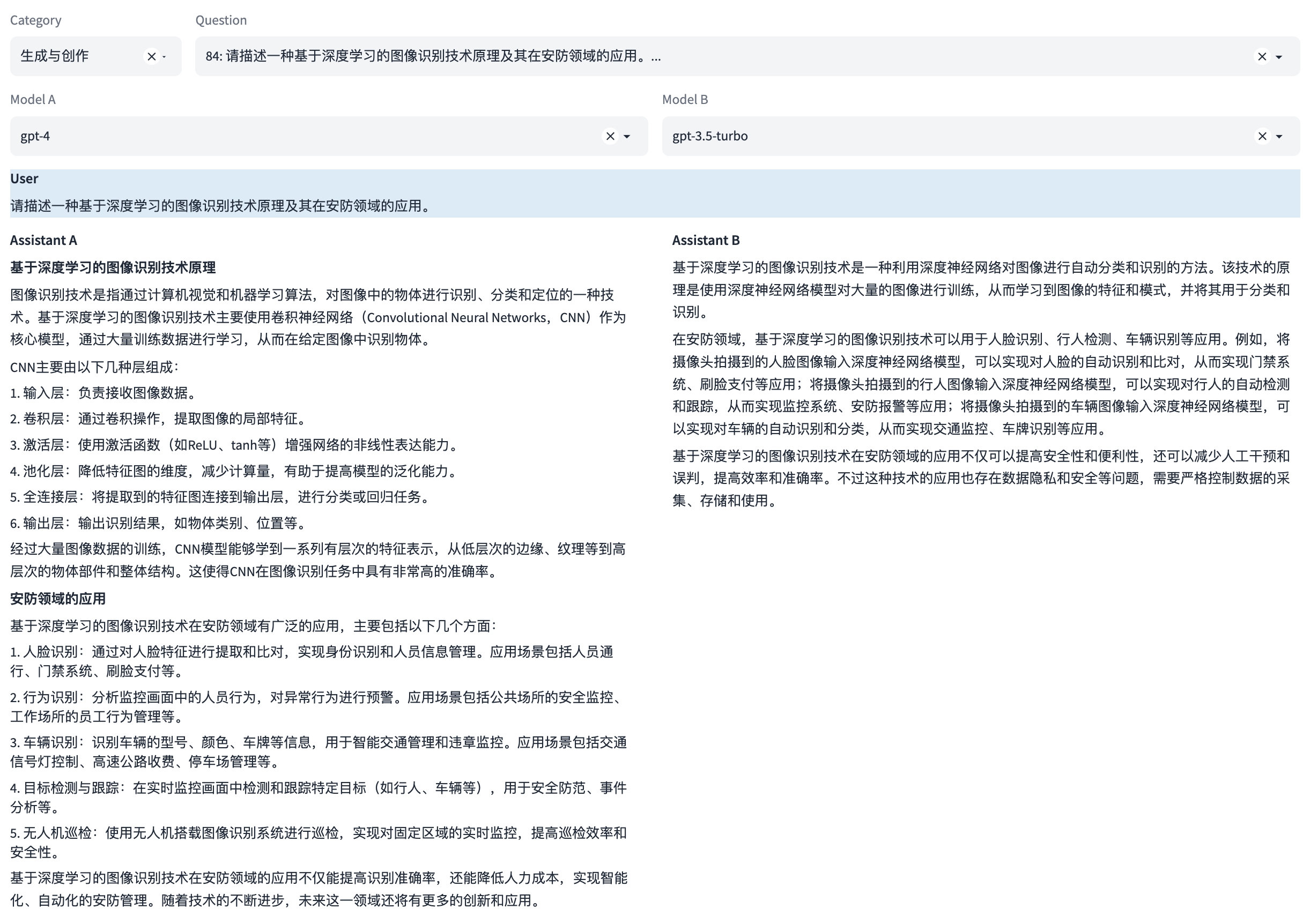

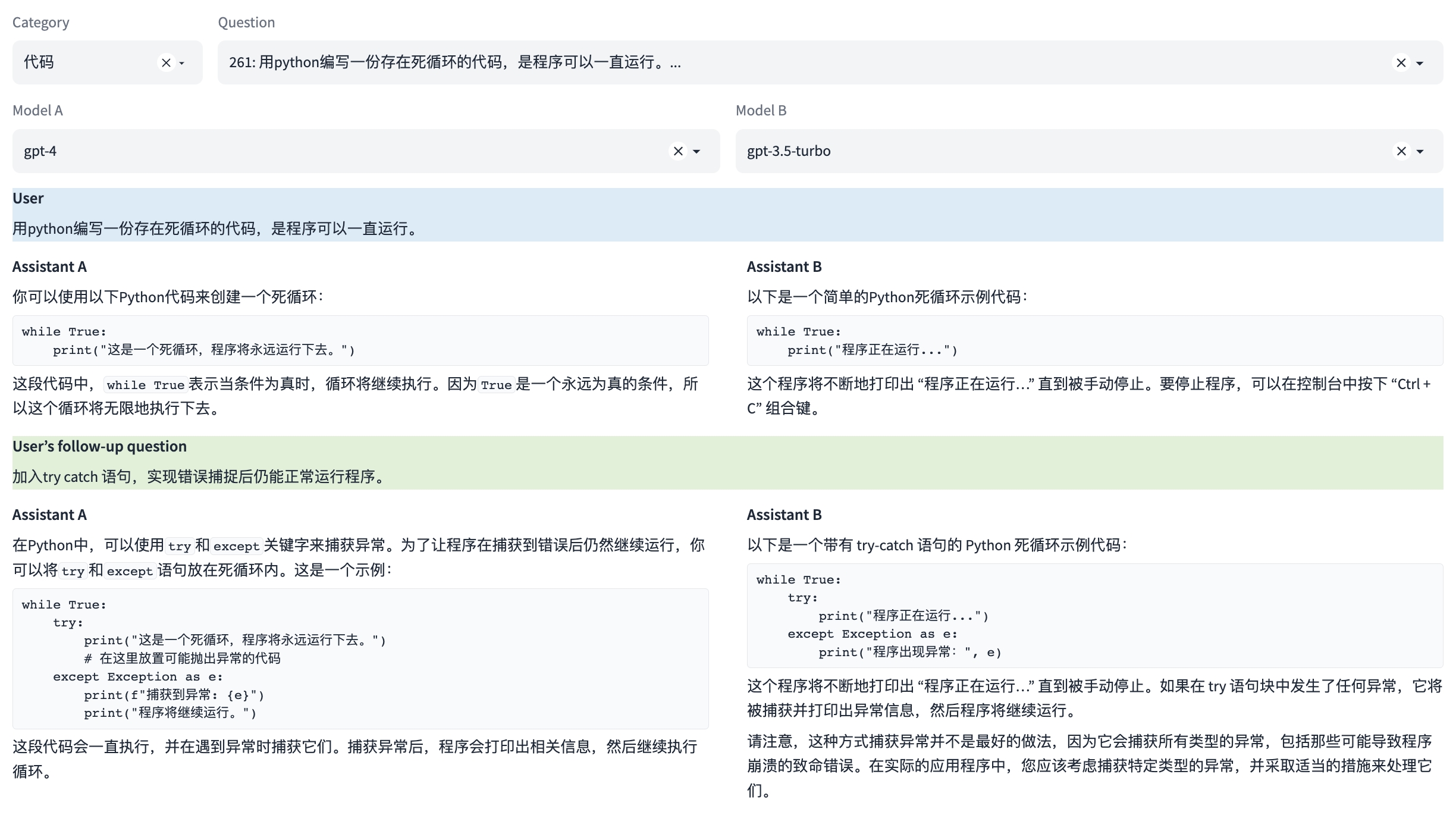

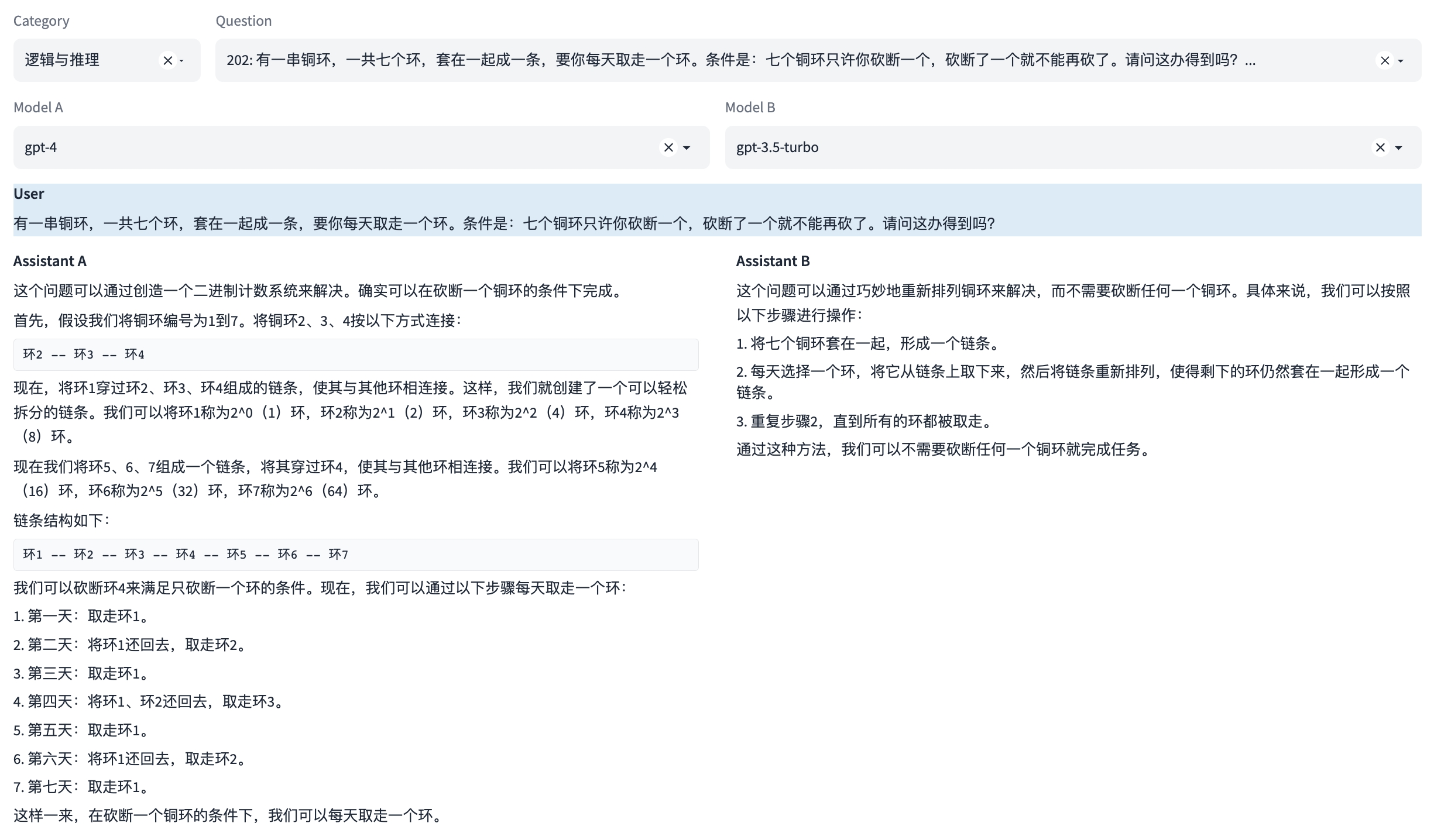

注:本示例中可同时评测多轮对话能力

注:本示例中可同时评测多轮对话能力

注:本示例中可同时评测多轮对话能力

注:本示例中可同时评测多轮对话能力

注:本示例中可同时评测多轮对话能力

注:本示例中可同时评测多轮对话能力

SuperCLUE中文大模型排行榜(2023年7月)

| 排名 | 模型 | 机构 | 总分 | 基础能力 | 中文特性 | 学术专业 | 许可证 |

|---|---|---|---|---|---|---|---|

| 🧝 | 人类 | CLUE | 83.66 | 85.03 | 82.29 | - | - |

| - | GPT-4 | OpenAI | 70.89 | 70.04 | 72.67 | 69.96 | 专有服务 |

| 🏅 | 文心一言(v2.2.0) | 百度 | 62.00 | 61.11 | 71.38 | 53.50 | 专有服务 |

| - | Claude-2 | Authropic | 60.94 | 62.01 | 61.18 | 59.63 | 专有服务 |

| - | gpt-3.5-turbo | OpenAI | 59.79 | 64.40 | 63.19 | 51.78 | 专有服务 |

| 🥈 | ChatGLM-130B | 清华大学&智谱AI | 59.35 | 53.78 | 71.39 | 52.89 | 专有服务 |

| 🥉 | 讯飞星火(v1.5) | 科大讯飞 | 58.02 | 63.32 | 65.72 | 45.03 | 专有服务 |

| - | Claude-instant-v1 | Authropic | 56.31 | 58.85 | 55.91 | 54.16 | 专有服务 |

| 4 | 360智脑(4.0) | 360 | 55.04 | 56.68 | 62.54 | 45.88 | 专有服务 |

| 5 | internlm-chat-7b | 上海AI实验室与商汤 | 53.91 | 54.85 | 61.35 | 45.53 | 开源-可商用 |

| 6 | ChatGLM2-6B | 清华大学&智谱AI | 53.85 | 55.60 | 63.59 | 42.37 | 开源-可商用 |

| 7 | MiniMax-abab5.5 | MiniMax | 53.06 | 53.61 | 62.79 | 42.77 | 专有服务 |

| 8 | 通义千问(v1.0.3) | 阿里巴巴 | 51.52 | 52.84 | 61.73 | 39.98 | 专有服务 |

| 9 | Baichuan-13B-Chat | 百川智能 | 49.35 | 50.46 | 55.38 | 42.21 | 开源-可商用 |

| 10 | BELLE-LLaMA-13B-2M-enc | 链家 | 46.60 | 48.71 | 52.99 | 38.10 | 开源-非商用 |

| 11 | IDEA-姜子牙-13B-v1.1 | 深圳IDEA研究院 | 43.80 | 47.55 | 48.61 | 35.26 | 开源-非商用 |

| 12 | phoenix-7B | 香港中文大学 | 41.57 | 45.39 | 44.62 | 34.70 | 开源-可商用 |

| 13 | MOSS-16B | 复旦大学 | 35.36 | 37.01 | 38.01 | 31.07 | 开源-可商用 |

| 14 | Llama-2-13B-chat | Meta | 34.26 | 35.85 | 37.37 | 29.57 | 开源-可商用 |

| 15 | Vicuna-13B | UC伯克利 | 31.70 | 34.61 | 33.71 | 26.80 | 开源-非商用 |

| 16 | RWKV-7B-World-CHNtuned | RWKV基金会 | 27.83 | 30.71 | 28.13 | 24.66 | 开源-可商用 |

2023年7月SuperCLUE基础能力榜单

| 排名 | 模型 | 平均分 | 语义理解 | 闲聊 | 对话 | 角色扮演 | 知识与百科 | 生成与创作 | 逻辑与推理 | 代码 | 计算 | 安全 |

|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 🧝 | 人类 | 85.03 | 90.17 | 71.53 | 77.99 | 82.19 | 97.44 | 68.79 | 90.55 | 90.45 | 94.97 | 86.22 |

| - | gpt-4 | 70.04 | 82.91 | 46.77 | 66.39 | 63.46 | 92.65 | 66.67 | 60.33 | 85.45 | 61.48 | 73.02 |

| - | gpt-3.5-turbo | 64.40 | 87.18 | 45.16 | 65.57 | 60.58 | 85.29 | 72.36 | 42.98 | 72.73 | 38.52 | 72.22 |

| 🏅️ | 讯飞星火(v1.5) | 63.32 | 78.26 | 45.90 | 59.84 | 55.88 | 73.48 | 54.92 | 54.70 | 60.00 | 76.86 | 71.54 |

| - | Claude-2 | 62.01 | 83.49 | 49.59 | 57.14 | 52.88 | 78.68 | 68.07 | 53.72 | 66.06 | 44.26 | 65.60 |

| 🥈 | 文心一言(v2.2.0) | 61.11 | 81.90 | 46.34 | 56.67 | 59.80 | 86.76 | 47.73 | 36.52 | 65.79 | 52.63 | 70.63 |

| - | Claude-instant-v1 | 58.85 | 76.52 | 50.00 | 58.20 | 55.77 | 77.04 | 61.48 | 40.00 | 66.97 | 33.61 | 67.77 |

| 🥉 | 360智脑(4.0) | 56.68 | 76.92 | 52.46 | 58.33 | 54.08 | 76.80 | 61.54 | 37.29 | 53.64 | 29.57 | 67.92 |

| 4 | ChatGLM2-6B | 55.60 | 74.36 | 44.35 | 55.74 | 56.73 | 76.47 | 51.22 | 40.50 | 41.82 | 45.08 | 66.67 |

| 5 | internlm-chat-7b | 54.85 | 80.34 | 48.39 | 55.74 | 55.77 | 77.94 | 36.59 | 37.19 | 51.82 | 34.43 | 68.25 |

| 6 | ChatGLM-130B | 53.78 | 70.94 | 45.97 | 56.56 | 61.54 | 75.74 | 55.28 | 29.75 | 45.45 | 31.15 | 63.49 |

| 7 | MiniMax-abab5.5 | 53.61 | 79.49 | 45.97 | 59.84 | 60.58 | 85.29 | 47.97 | 29.75 | 30.00 | 31.97 | 61.11 |

| 8 | 通义千问 | 52.84 | 74.77 | 45.97 | 57.98 | 53.00 | 76.69 | 38.89 | 33.06 | 46.67 | 39.67 | 60.40 |

| 9 | Baichuan-13B-Chat | 50.46 | 64.10 | 41.94 | 50.00 | 52.88 | 75.00 | 57.72 | 27.27 | 40.91 | 31.15 | 60.32 |

| 10 | BELLE-13B | 48.71 | 68.38 | 46.77 | 51.64 | 53.85 | 64.71 | 25.20 | 32.23 | 48.18 | 31.97 | 63.49 |

| 11 | IDEA-姜子牙-13B-v1.1 | 47.55 | 70.09 | 49.19 | 48.36 | 48.08 | 58.82 | 32.52 | 34.71 | 21.82 | 45.08 | 63.49 |

| 12 | Phoenix-7B | 45.39 | 66.67 | 41.94 | 43.44 | 43.27 | 55.15 | 44.72 | 31.41 | 36.36 | 33.61 | 55.56 |

| 13 | MOSS-16B | 37.01 | 54.70 | 39.52 | 40.16 | 45.19 | 35.29 | 34.96 | 24.79 | 32.73 | 27.05 | 37.30 |

| 14 | Llama-2-13B-chat | 35.85 | 52.14 | 41.94 | 40.98 | 32.69 | 33.82 | 38.21 | 28.93 | 23.64 | 27.05 | 38.10 |

| 15 | Vicuna-13B | 34.61 | 49.57 | 33.06 | 32.79 | 37.50 | 25.74 | 30.89 | 27.27 | 40.91 | 35.25 | 35.71 |

| 16 | RWKV-7B-World-CHNtuned | 30.71 | 31.62 | 20.16 | 22.13 | 26.92 | 27.21 | 23.58 | 22.31 | 36.36 | 60.66 | 36.51 |

2023年7月SuperCLUE中文特性榜单

| 排名 | 模型 | 平均分 | 字形和拼音 | 字义理解 | 句法分析 | 文学 | 诗词 | 成语 | 歇后语 | 方言 | 对联 | 古文 |

|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 🧝 | 人类 | 82.29 | 96.01 | 83.15 | 62.71 | 91.47 | 90.79 | 92.38 | 83.78 | 69.21 | 70.00 | 83.40 |

| - | gpt-4 | 72.67 | 62.83 | 68.07 | 85.48 | 88.08 | 75.68 | 95.12 | 70.15 | 38.40 | 71.52 | 67.31 |

| 🏅️ | ChatGLM-130B | 71.39 | 48.67 | 68.07 | 75.00 | 83.44 | 84.68 | 95.94 | 67.16 | 45.60 | 70.86 | 72.12 |

| 🥈 | 文心一言(v2.2.0) | 71.38 | 59.34 | 70.34 | 73.33 | 86.58 | 82.88 | 95.12 | 60.31 | 37.60 | 71.03 | 73.79 |

| 🥉 | 讯飞星火(v1.5) | 65.72 | 47.32 | 68.38 | 77.42 | 72.03 | 69.09 | 89.43 | 59.85 | 35.77 | 71.23 | 63.46 |

| 4 | ChatGLM2-6B | 63.59 | 45.13 | 60.50 | 66.13 | 78.81 | 63.06 | 89.43 | 64.18 | 33.60 | 64.24 | 66.35 |

| - | gpt-3.5-turbo | 63.19 | 46.02 | 69.75 | 75.81 | 75.50 | 57.66 | 89.43 | 55.97 | 36.00 | 57.62 | 66.35 |

| 5 | MiniMax-abab5.5 | 62.79 | 46.90 | 57.98 | 63.71 | 75.50 | 71.17 | 86.99 | 60.45 | 41.60 | 58.94 | 62.50 |

| 6 | 360智脑(4.0) | 62.54 | 45.45 | 63.83 | 63.53 | 71.43 | 70.73 | 97.06 | 60.47 | 38.46 | 64.96 | 73.21 |

| 7 | 通义千问 | 61.73 | 41.59 | 60.87 | 60.66 | 73.65 | 67.89 | 88.24 | 51.91 | 40.68 | 68.97 | 57.89 |

| 8 | internlm-chat-7b | 61.35 | 41.59 | 58.82 | 62.10 | 76.16 | 68.47 | 86.18 | 61.94 | 32.80 | 57.62 | 65.38 |

| - | Claude-2 | 61.18 | 48.67 | 70.94 | 70.16 | 67.55 | 54.05 | 83.74 | 58.21 | 36.00 | 60.67 | 59.62 |

| - | Claude-instant-v1 | 55.91 | 43.36 | 62.16 | 72.13 | 62.91 | 50.91 | 84.87 | 47.73 | 31.20 | 56.38 | 45.19 |

| 9 | Baichuan-13B-Chat | 55.38 | 45.13 | 58.82 | 50.81 | 73.51 | 70.27 | 75.61 | 47.01 | 33.60 | 44.37 | 54.81 |

| 10 | BELLE-13B | 52.99 | 42.48 | 55.46 | 67.74 | 56.29 | 46.85 | 78.05 | 38.06 | 33.60 | 59.60 | 49.04 |

| 11 | IDEA-姜子牙-13B-v1.1 | 48.61 | 28.32 | 54.62 | 51.61 | 56.29 | 51.35 | 63.41 | 42.54 | 36.00 | 48.34 | 51.92 |

| 12 | Phoenix-7B | 44.62 | 30.09 | 51.26 | 43.55 | 51.66 | 45.95 | 65.85 | 35.07 | 32.00 | 45.03 | 44.23 |

| 13 | MOSS-16 | 38.01 | 32.74 | 43.70 | 36.29 | 40.40 | 32.43 | 60.98 | 32.09 | 31.20 | 31.13 | 40.38 |

| 14 | Llama-2-13B-chat | 37.37 | 31.86 | 40.34 | 49.19 | 37.75 | 33.33 | 43.90 | 32.09 | 32.00 | 33.77 | 40.38 |

| 15 | Vicuna-13B | 33.71 | 21.24 | 34.45 | 45.16 | 29.14 | 22.52 | 33.33 | 36.57 | 22.40 | 49.67 | 38.46 |

| 16 | RWKV-7B-World-CHNtuned | 28.13 | 25.66 | 26.05 | 25.00 | 29.80 | 26.13 | 45.53 | 17.16 | 20.00 | 36.42 | 27.88 |

2023年7月SuperCLUE开源榜单

| 排名 | 模型 | 机构 | 总分 | 基础能力 | 中文特性 | 学术专业 | 许可证 |

|---|---|---|---|---|---|---|---|

| 🧝 | 人类 | CLUE | 83.66 | 85.03 | 82.29 | - | - |

| 🏅️ | internlm-chat-7b | 上海AI实验室与商汤 | 53.91 | 54.85 | 61.35 | 45.53 | 开源-可商用 |

| 🥈 | ChatGLM2-6B | 清华大学&智谱AI | 53.85 | 55.60 | 63.59 | 42.37 | 开源-可商用 |

| 🥉 | Baichuan-13B-Chat | 百川智能 | 49.35 | 50.46 | 55.38 | 42.21 | 开源-可商用 |

| 4 | BELLE-LLaMA-13B-2M-enc | 链家 | 46.60 | 48.71 | 52.99 | 38.10 | 开源-非商用 |

| 5 | IDEA-姜子牙-13B-v1.1 | 深圳IDEA研究院 | 43.80 | 47.55 | 48.61 | 35.26 | 开源-非商用 |

| 6 | phoenix-7B | 香港中文大学 | 41.57 | 45.39 | 44.62 | 34.70 | 开源-可商用 |

| 7 | MOSS-16B | 复旦大学 | 35.36 | 37.01 | 38.01 | 31.07 | 开源-可商用 |

| 8 | Llama-2-13B-chat | Meta | 34.26 | 35.85 | 37.37 | 29.57 | 开源-可商用 |

| 9 | Vicuna-13B | UC伯克利 | 31.70 | 34.61 | 33.71 | 26.80 | 开源-非商用 |

| 10 | RWKV-7B-World-CHNtuned | RWKV基金会 | 27.83 | 30.71 | 28.13 | 24.66 | 开源-可商用 |